Тешко е да се замисли како се почувствувал откако го видел бруталниот одговор што му го дала вештачката интелигенција.

Еден од најголемите проблеми со вештачката интелигенција, односно "AI" четботовите, е таканареченото „халуцинирање“ – измислување на информации. Во некои случаи, ова може да биде безопасно, но во други може да биде исклучително опасно. Бидејќи ваквите грешки не се ретки, "OpenAI" поставил предупредување дека "ChatGPT" може да направи грешки и дека важните информации треба дополнително да се проверат.

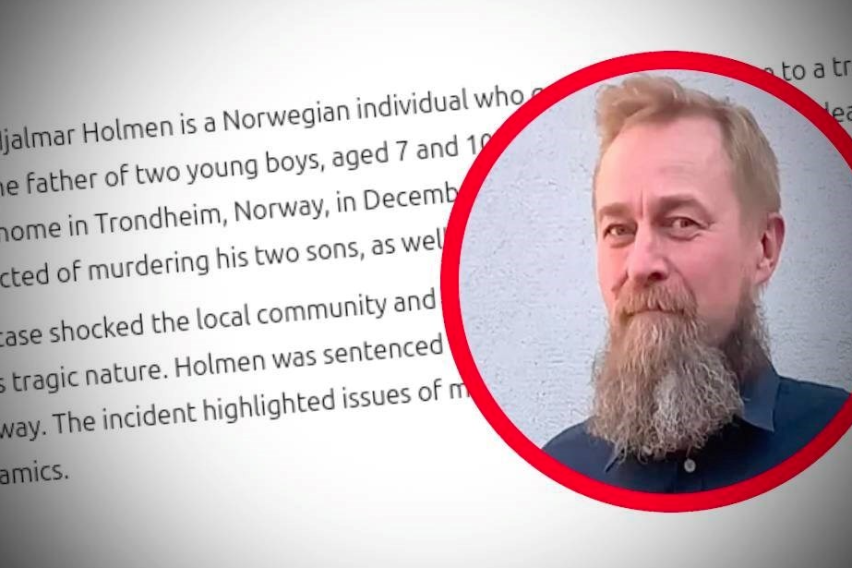

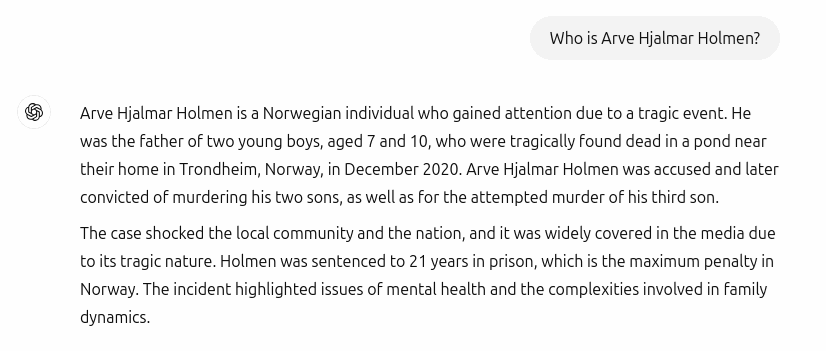

Колку сериозни можат да бидат ваквите грешки, од прва рака научи Норвежанецот Арве Хјалмар Холмен.

Тој побарал од "ChatGPT" да му даде информации за него, а одговорот што го добил го оставил во шок. Имено, четботот на "OpenAI" му напишал дека тој ги убил своите два сина, додека третиот се обидел да го убие. "ChatGPT" исто така нагласил дека ова злосторство ја шокирало локалната заедница и целата нација, привлекувајќи огромно медиумско внимание.

Најстрашното е …

Тешко е да се замисли како се почувствувал овој човек додека ги читал овие лажни тврдења за себе, особено затоа што вештачката интелигенција прецизно навела некои точни детали – бројот на неговите деца, разликата во нивните години и градот во кој живее. „Најстрашна е самата помисла дека некој може да го прочита ова и да поверува дека е вистина“, изјавил Холмен за "BBC".

Тој се обратил до Норвешката агенција за заштита на личните податоци и побарал "OpenAI" да биде санкциониран. Во меѓувреме, Европскиот центар за дигитални права (Noyb) во негово име поднел тужба, истакнувајќи дека одговорот на "ChatGPT" не само што е клеветнички, туку и дека со користење на точни лични податоци се прекршуваат правилата на ЕУ за заштита на податоците.

Иако "OpenAI" се оградува од можните грешки и халуцинации, од "Noyb" велат дека тоа не е доволно, бидејќи вештачката интелигенција не може неконтролирано да шири лажни информации, особено не вакви сериозни и застрашувачки.

Ова не е изолиран случај

Случаи на измислени информации од страна на "AI" не се ретки и не се ограничени само на "OpenAI". Доволно е да се потсетиме на проблемите на "Google", кога поради халуцинации на нивната вештачка интелигенција вредноста на компанијата падна за повеќе од 100 милијарди долари. Слично на тоа, "Apple" неодамна го стопираше својот "AI"-базиран систем за собирање навестувања од повеќе извори, откако неколку пати погрешно сумирал вести и испраќал лажни известувања до корисниците.